Durch eine Logfile-Analyse erhält man wichtige Erkenntnisse darüber, welche Suchmaschinen Bots und Web Scraper eine Website besuchen und Daten sammeln. Die Macher des beliebten Screaming Frog SEO Spider haben einen SEO Log File Analyser entwickelt. Damit können Logfiles detailliert analysiert und bewertet werden. Die Daten werden übersichtlich in Tabellen und anschaulichen Diagrammen dargestellt.

Inhaltsverzeichnis

Was ist ein Logfile?

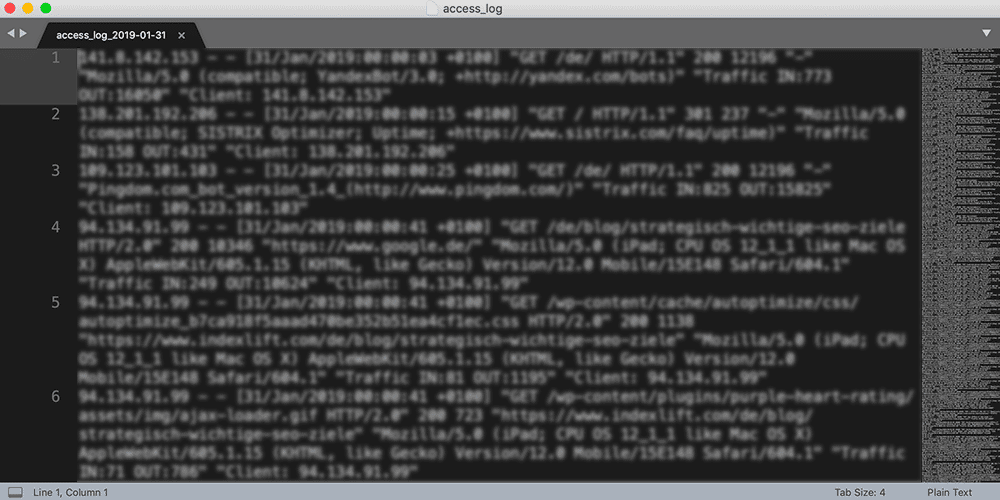

Das Web-Logfile (Logdatei) ist eine Ereignisprotokolldatei, das alle Aktionen und Prozesse auf einem Webserver automatisch erfasst und protokolliert. Durch Verbindung mit dem Webserver, zum Beispiel via SFTP, kann man die Logfiles abrufen. Diese Dateien können mit einem Texteditor geöffnet werden, wirken jedoch für den Laien kryptisch. Werden viele Bot-Zugriffe protokolliert, kann eine Logfile-Datei groß und unübersichtlich werden, so dass selbst erfahrene SEO’s diese Daten mühsam aufbereiten müssen, um sinnvolle Bewertungen durchführen zu können. Der SEO Log File Analyser vereinfacht die Analysen und Bewertungen enorm.

Welche Informationen liefert eine Logfile-Analyse?

Suchmaschinenoptimierer analysieren Webserver-Logfiles, um das Crawlingverhalten von Suchmaschinen zu ermitteln und daraus geeignete SEO-Maßnahmen abzuleiten. Unabhängig vom Webserver besitzen Logfiles i .d. R. die selben Informationen, die in ihrer Abfolge variieren können.

| Logfile-Eintrag | Bemerkung |

| IP-Adresse | Normierte Ziffernfolge, über die jeder Zugriff eindeutig identifiziert wird (z. B. 64.233.191.255). |

| Abfragedatum | Zu welchem Zeitpunkt der Zugriff erfolgte. |

| Method | Die Methode der Anfrage, zum Beispiel: Get-Method. |

| URL-Request | Die angefragte URL. |

| Response-Code | Der Response-Code, den der Webserver für den URL-Request geliefert hat, zum Beispiel „200“ oder „404“. |

| Response-Size | Die Response-Größe in Bytes. |

| Previous-URL | Die URL, auf die der vorherige Zugriff erfolgte. |

| User Agent | Der Name, mit dem sich die Client-Software oder der User identifiziert. |

Warum ist eine Logfile-Analyse aus SEO-Sicht wichtig?

Durch eine Logfile-Analyse erfährt man, wie Suchmaschinen eine Website verarbeiten. So lässt sich zum Beispiel herausfinden, welche User Agents eine Website verarbeitet haben und noch detaillierter: Welche URLs der GoogleBot Smartphone verarbeitet hat und welche Response-Codes vom Webserver geliefert wurden. Daraus können effektive Optimierungen für eine bessere Website-Architektur, Performance und Usability abgeleitet werden. Ungewünschte Weiterleitungen und nicht verfügbare URLs können so behoben werden, um eine bessere Crawlability zu ermöglichen.

John Mueller von Google hat sich bereits zu Logfiles geäußert und bemängelt, dass sie unterschätzt werden, obwohl sie wichtige Informationen liefern:

@glenngabe Log files are so underrated, so much good information in them.

— 🍌 John 🍌 (@JohnMu) 5. April 2016

Screaming Frog SEO Log File Analyser

Der Screaming Frog SEO Log File Analyser bietet Möglichkeiten, Logfiles zu importieren und stellt die Logfile-Daten übersichtlich in Tabellen und Diagrammen dar. Im Vergleich zu einem herkömmlichen Texteditor bietet die Software enorme Vorteile.

Was kostet der SEO Log File Analyser

Die Software steht kostenlos zur Verfügung – allerdings mit ein paar Einschränkungen: Log Event Limit: 1.000 Zeilen, Projekt Limit: 1 Projekt, technischer Support: nein. Die uneingeschränkte Lizenz bekommt man bereits für faire £ 99.00 pro Jahr (≈ 120,00 €).

Was kann der SEO Log File Analyser?

- Identifizierte gecrawlte URLs

Sehe und analysiere genau, welche URLs Googlebot und andere Such-Bots wann und wie oft verarbeitet haben. - Finde defekte Links und Fehler

Entdecke alle Antwortcodes, fehlerhafte Links und Fehler, auf die Suchmaschinen-Bots beim Crawlen gestoßen sind. - Crawlability verbessern

Analysiere die am wenigsten verarbeiteten URLs und Verzeichnisse, um Verschwendung zu erkennen und die Crawlability zu verbessern. - Nicht-gecrawlte & verwaiste URLs (Orphan Pages) suchen

Importiere eine Liste von URLs und vergleiche sie mit Logfiles, um verwaiste oder unbekannte URLs zu identifizieren, die der Googlebot nicht durchsucht hat. - Analysiere das Crawlverhalten von Bots

Erhalte einen Einblick, welche Such-Bots am häufigsten auf die Website zugreifen, wie viele URLs täglich durchsucht werden und wie viele Bot-Ereignisse es gibt. - Audit-Weiterleitungen

Suche nach temporären und permanenten Weiterleitungen von Such-Bots, die sich von denen in einem Browser oder simulierten Crawl unterscheiden können. - Große und langsame Seiten erkennen

Überprüfe, wie viele Bytes durchschnittlich heruntergeladen wurden und wie viel Zeit benötigt wird, um große Seiten/Dateien zu verarbeiten.

5 Schritte einer Logfile-Analyse

- Zunächst installiert man den SEO Log File Analyser auf seinem System (PC/Mac). (Download now!)

- Im nächsten Schritt müssen die Logfiles organisiert werden. Du lädtst sie via SFTP von meinem Webserver. Sie sind im Verzeichnis logs gespeichert – im Root-Verzeichnis. Die Dateien sehen so aus: access_log_2019-03-28.gz Für jeden Tag liegt eine .gz-Datei vor. Du musst also viele Dateien downloaden, um einen größeren Zeitraum analysieren zu können.

- Nun legst Du im SEO Log File Analyser ein neues Projekt an. Dadurch klickst Du im Menü auf den + New-Button. Im Popup bestimmt man einen Projekt-Namen und wählt die Timezone aus. (Dtl: UTC+02:00)

- Durch Klicken auf den Button Import > Log File wählst Du die gewünschten Logfiles aus, die vom Webserver heruntergeladen wurden. Es erscheint wieder ein Popup in dem Du die Domain angibst. Nun werden die Daten importiert.

- Oben rechts solltest Du nun einen geeigneten Zeitraum wählen, zum Beispiel den letzten Monat.

SEO Log File Analyser-Berichte

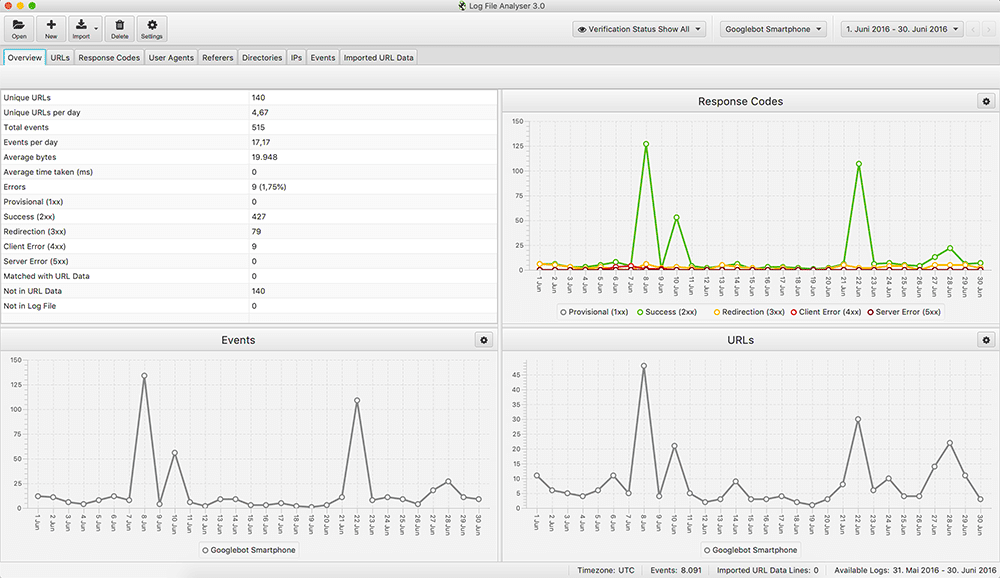

Overview

Der Reiter Overview liefert verschiedene Informationen zu den ermittelten URLs, Response Codes, Events – sowie eine tabellarische Übersicht mit den wichtigsten Kennzahlen der Logfile-Daten.

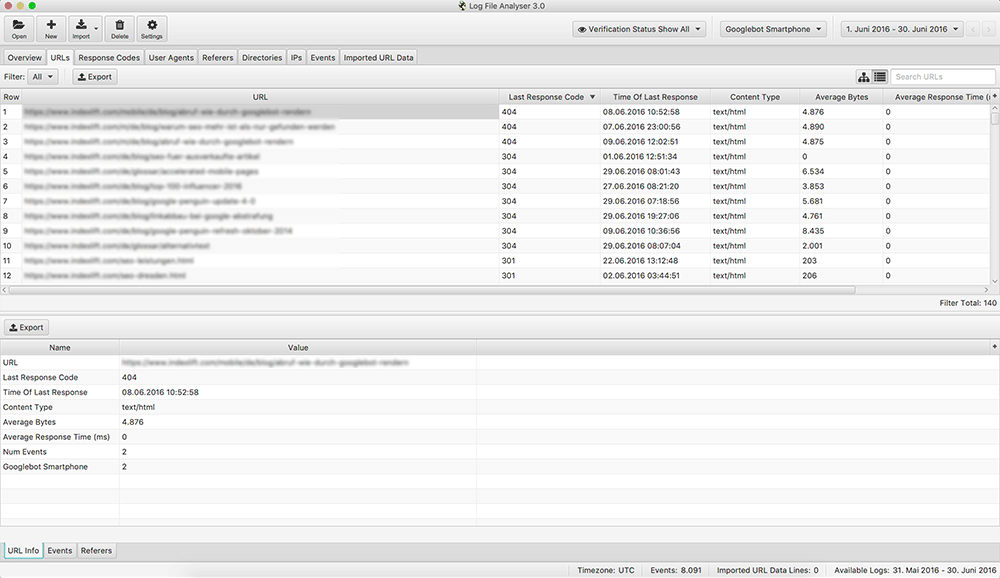

URLs

Der Reiter URLs listet alle gecrawlten URLs (Seiten, Bilder, etc.) auf. Für jede URL werden der zuletzt ermittelte Response-Code, der Zeitpunkt der Verarbeitung, der Content Type, die Dateigröße, uvw. dokumentiert. Wie in allen Berichten können diese Daten für Alle Bots oder einem ausgewählten Bot gefiltert werden.

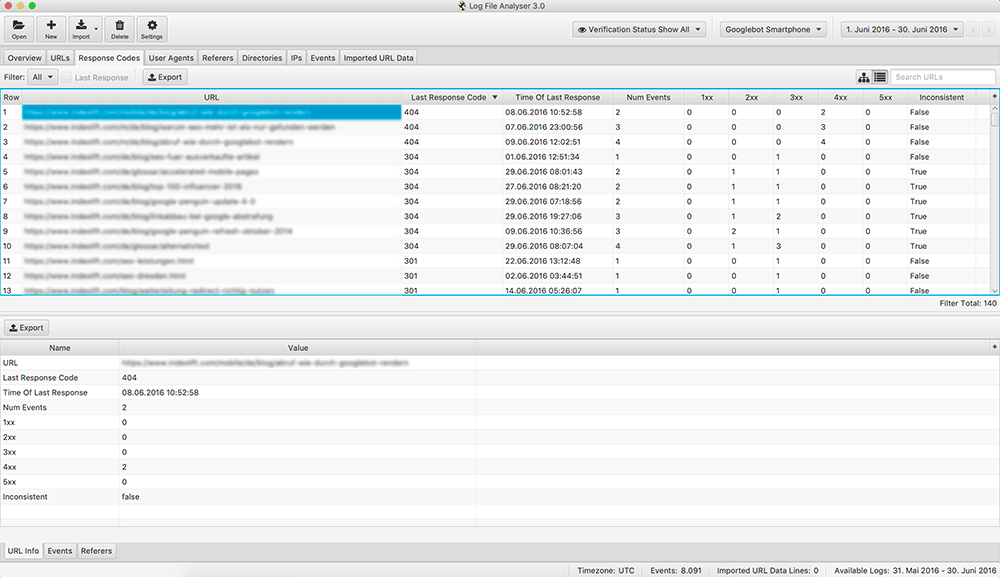

Response Codes

Der Reiter Response Codes bietet eine ähnliche Übersicht wie der Bericht URLs, jedoch mit Fokus auf die Response Codes der verarbeiteten URLs. Für jede URL wird ersichtlich, welche Response Codes sie geliefert haben – also nicht nur der zuletzt ermittelte Response Code, sondern eine Auflistung aller Response Codes.

User Agents

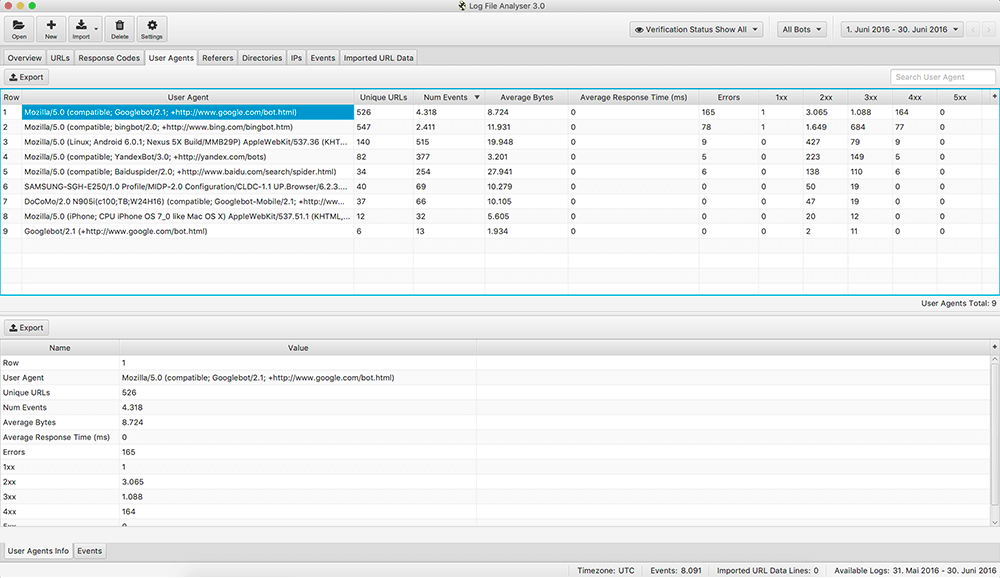

Der Bericht User Agents ist sehr aufschlussreich, weil er eine Auflistung aller identifizierten Bots liefert, inklusive Angaben zu den verarbeiten URLs (Wie aktiv war der Bot?), der Events, verarbeiteten Bytes, Fehler, Response Times in ms, etc.

Weitere Berichte

Ergänzend zu diesen Berichten, bietet der SEO Log File Analyser folgende Berichte für weitere Bewertungen:

| Bericht | Bemerkung |

| Referers | Zeigt die Anzahl der Verweis-Ereignisse für jede erkannte URL. |

| Directories | Hier können die am häufigsten und am wenigsten verarbeiteten Verzeichnisse und Abschnitte der Website analysiert werden. |

| IPs | Auflistung verschiedener Crawl-Daten nach IP-Adresse sortiert. |

| Events | Auflistung verschiedener Events nach URLs sortiert. |

Schlussbemerkungen

Eine Analyse der Webserver-Logfiles (access logs) bietet sich mit dem SEO Log File Analyse von Screaming Frog an, weil die Daten bequemer als mit einem Texteditor analysiert werden können. Das Crawl-Verhalten von Google und anderen Such-Bots zu bewerten, wird dadurch kinderleicht und ist spürbar schneller abgeschlossen. Ich kenne keine Software, die eine professionelle Logfile-Analyse einfacher gestaltet.

Log-Daten können weder mit Google Analytics noch einer anderen Tracking-Software ermittelt werden – Google Analytics ermittelt das Verhalten der Nutzer einer Website. Auch in der Google Search Console sind diese Daten nicht verfügbar.

Kommentar verfassen