Bereits mehrfach habe ich den Audisto Crawler für Website Audits verwendet. Der robuste Cloud Crawler bietet interessante Features. Endlich unterstützt Audisto auch das Rendering von Seiten und die Javascript-Ausführung. Überzeugt der Audisto Crawler und ist er für tiefgründige Website Audits empfehlenswert? Hier erfährst Du alles Wissenswerte über den Website Crawler aus dem Hause Audisto.

Inhaltsverzeichnis

Was ist der Audisto Crawler?

Der Audisto Crawler ist ein Onpage-Crawler zur Analyse von Fehlermustern, zur Identifizierung technischer Probleme und für datengestützte Entscheidungen über Website-Verbesserungen. Audisto stellt in den Crawl-Berichten keine Empfehlungen bereit. Deshalb sind die Anwender des Cloud Crawlers eher technisch erfahrene SEOs, Webmaster und Web-Entwickler.

Wichtige Crawl-Settings für Website Audits

- Skalierbarer Cloud Crawler Software für die Verarbeitung bis zu 20 Mio. Seiten

- Professionelles Crawling-Tool für Onpage-, Content- und Strukturanalysen

- Rendering und Javascript-Ausführung von HTML-Seiten

- Crawling mit bis zu 24 parallelen Threads

- Analyse von Fehlermustern in Code und Vorlagen zur Ermittlung technischer Probleme

- Detaillierte Berichte, um Trends zu erkennen und Fehlkonfigurationen zu beheben

- Crawlability-Analyse

- Analyse der Linkstruktur auf der Website

- Indexierbarkeits- und Noindex-Checker

- Test von hreflang-Tags und Sprachdefinitionen

- Aufspüren von Duplicate Content

- Domain-übergreifendes Crawling mehrerer Websites

- Automatisierte technische Website-Audits

- Vollständige Daten-Exporte

- Eine Overload Protection drosselt das Crawling, wenn zu viele Fehler auftreten

- Bewertung der Web Vitals für alle Seiten, Cluster und im URL Report

- Historische Trenddaten für alle KPIs, Hinweise und Zustände für regelmäßige automatisierte Crawls

Audisto Bewertung

Audisto Crawler ist für SEO Audits großer Websites und Shops empfehlenswert. Die hochentwickelte Cloud Crawler Software eignet sich besonders für technische Analysen, sowie zur Onpage-, Inhalts- und Strukturanalyse. Aufgeräumte Dashboards liefern tiefgreifende Informationen für Profis. Für SEO Neueinsteiger eignet sich Audisto weniger, weil keine Handlungsempfehlungen erstellt werden. Regelmäßige automatisierte Crawls liefern Hinweise und Zustände zu wichtigen Kennzahlen. So kann man unverzüglich auf Anomalien reagieren.

| Gesamt | 4/5 | |

| Benutzerfreundlichkeit | 3.5/5 | |

| Funktionsumfang | 4/5 | |

| Dokumentation (FAQ) | 4/5 | |

| Preis-Leistungs-Verhältnis | 4/5 | |

| Empfehlungswahrscheinlichkeit | 4/5 |

Audisto Crawler Preise

Das Audisto-Preiskonzept finde ich fair und transparent. Denn für ein Crawling-Projekt bestimmt man die Anzahl der zu crawlenden URLs. Das erfolgt anhand eines skalierbaren Schiebereglers, mit dem man den Crawlumfang zwischen 10.000 bis zu 20.000.000 HTML-Seiten pro Crawl festlegt. Der Umfang bestimmt den Preis, beginnend ab 99,00 EUR bei monatlicher Zahlung. Im gebuchten Zeitraum können beliebig viele Projekt-Crawls durchgeführt werden, abhängig vom gebuchten Kontingent pro Crawl.

Möchte man den Audisto Crawler langfristig nutzen, bietet sich eine preisreduzierte jährliche Zahlung an. Vor allem empfehlenswert, wenn man regelmäßig automatisierte Website-Crawls durchführen möchte, siehe Crawl History.

Audisto Projekt konfigurieren

Die Konfiguration ist denkbar einfach. Zunächst bestimmt man den Crawl-Umfang für das Projekt und gibt anschließend den Startpunkt für das Crawling an. Es können auch mehrere Starting points festgelegt werden, zum Beispiel die Startseite der Website und eine XML-Indexdatei der Sitemaps.

- Crawl Speed Konfiguration (Parallel Downloads & Request Delay)

- Festlegen der Standpunkte eines Crawls (Startseite, XML Sitemap)

- Automatischer Überlastschutz zur Drosselung der Crawlgeschwindigkeit, wenn zu viele Fehler auftreten.

- Festlegung von Limits (Maximale Crawltiefe, Maximale HTML Seiten)

- Festlegen, ob alle Subdomains gecrawlt werden sollen

- Mobiles oder Desktop Crawling auswählen

- Umgang mit externen URLs bestimmen

- Rendering und JavaScript-Ausführung aktivieren

- Feinabstimmung des Verhaltens vom HTML- und HTTP-Header-Parser

- robots.txt parsen oder durch custom robots.txt-Anweisungen überschreiben

- Connection Handling (HTTP 1.1 vs. HTTP 1.1 with connection reuse support)

- SSL Certificate Handling (Relaxed vs. Strict)

- Vordefinierte Cookies festlegen, die mit jeder Anfrage gesendet werden

- Vordefinierte HTTP-Header festlegen, die mit jeder Anfrage gesendet werden

- HTTP-Authentifizierung (Benutzer und Passwort für die HTTP-Authentifizierung)

- Erstellen individueller URL Normalization-Regeln

- Erstellen individueller URL Rewriting-Regeln

- Definition von Clustern als Filter für Crawl-Berichte

Endlich wird das Rendering und die Javascript-Ausführung von HTML-Seiten vom Audisto Crawler unterstützt, hier mehr. Audisto verwendet einen aktuellen Chrome-Browser, um Seiten ähnlich wie Suchmaschinen und Ihre Nutzer zu gestalten. Beim Rendering werden häufig mehr URLs entdeckt. Das hat auch zur Folge, dass Crawls mit Javascript um den Faktor zehn oder mehr langsamer sind. Der Audisto Crawler hat derzeit einige Einschränkungen: Es werden nur GET-Anfragen ausgeführt. POST, PUT, DELETE usw. werden abgebrochen. Cache-bezogene HTTP-Header werden ignoriert.

Current Crawl

Crawl Report

Der Crawl Report ist übersichtlich gestaltet und liefert eine Sammlung wichtiger SEO-Kennzahlen. Man bekommt ein erstes Gefühl zum Optimierungszustand der Website. Ich finde den Crawl Report gut gelöst.

Schwerpunkte vom Crawl Report

- Crawl Details: URLs Crawled, URLs Analyzed, Links Analyzed, Time Spend

- Status: Crawled, Robots.txt Excluded, Not HTML, External URL

- HTTP Response Status Code

- Indexability of HTML Documents: Indexable, Robots Noindex, Canonical Link

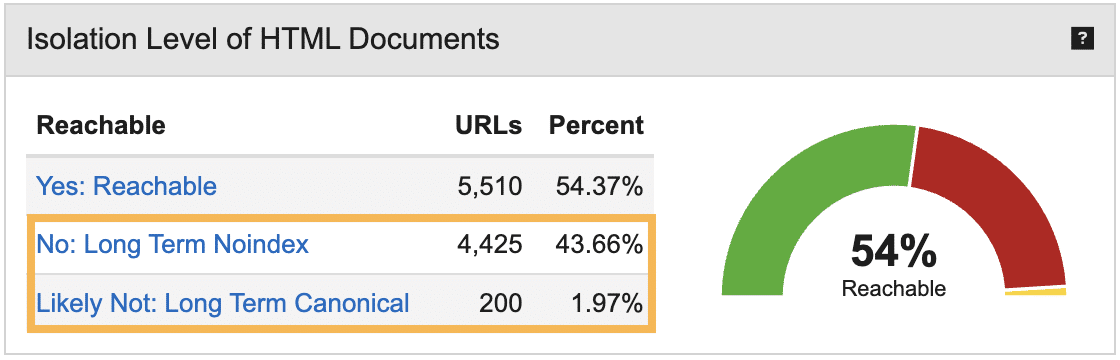

- Isolation Level of HTML Documents: Reachable, Long Term Noindex, Long Term Canonical

- Crawled Level

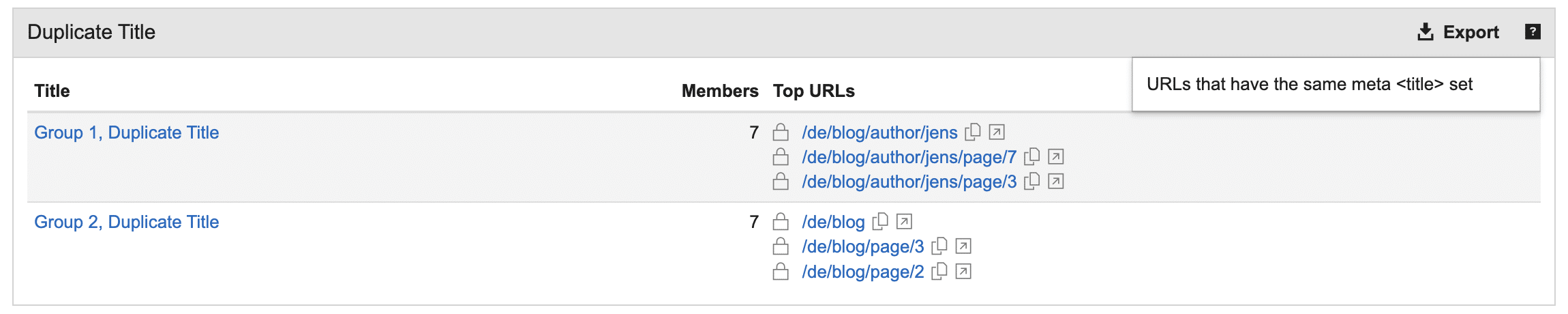

- Duplicate Content: Title, Meta Description, Page Body, Similar URLs

- Host Statistics

- Content Type

Crawl Berichte

Jeden Bericht einzeln vorzustellen, würde diesen Beitrag überladen. Deshalb liste ich hier die wichtigsten Berichte auf.

| Current Crawl | Enthaltene Berichte |

| Crawl Info | Starting Points, Errors, Logs, Scripting Issues, robots.txt, URL Rewrites |

| Structure | Clusters, Levels, Hosts, Links, External URLs, Similar URLs |

| Performance | Response Times, File Sizes, Web Vitals |

| On-page | Hints, Duplicate Content, Localization, Content Types, Hreflang |

| Ranks | Pagerank, Cheirank, 2D-Rank, Potentials |

Persönliche Eindrücke

Navigation anfangs etwas sperrig

Trotz der übersichtlichen und reduzierten Benutzeroberfläche klickte ich anfangs viele Audisto-Berichte durch, bis ich den Richtigen gefunden habe. Man muss sich anfangs Zeit nehmen und sich mit der Navigation und Struktur beschäftigen, um mit Audisto warm zu werden. Aber das trifft für die meisten SEO Spider zu.

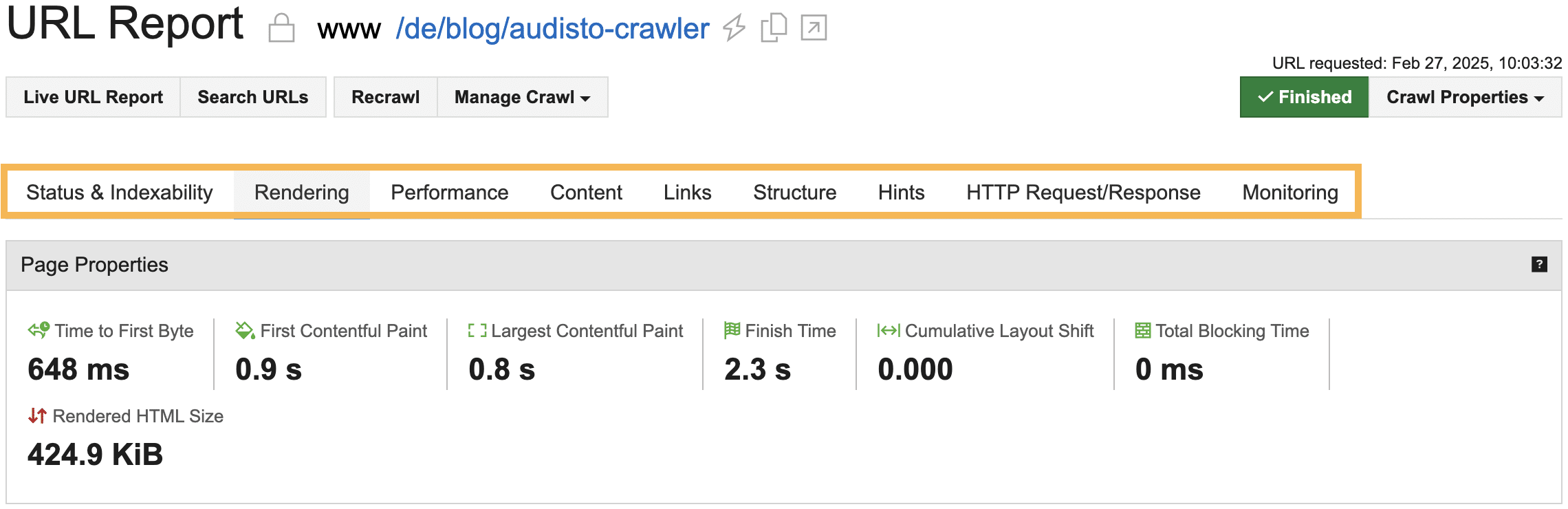

Zum Beispiel wollte ich alle Crawling-Daten für eine bestimmte Seite bewerten. Doch welcher Bericht stellt einen URL-Filter mit den gewünschten Daten bereit? Die Lösung ist Search URLs › URL Report im Crawl Report. Den Bericht finde ich sehr hilfreich, weil viele wertvolle Informationen einer Seite bereitgestellt werden, unter anderem Javascript-Fehlermeldungen, das Parsed HTML und der Navigation Path. Mit dem URL Report kann man sehr spezifisch arbeiten und einzelne Seiten optimieren.

Fehlende Filter und Sortierung

Die Berichte vom Audisto Crawler basieren auf Diagrammen und Datentabellen. Ich finde sie übersichtlich, doch oft funktional zu stark reduziert. Denn im Vergleich mit anderen Crawling Tools stellt Audisto keine Filter bereit, um Tabelleninhalte einzuschränken. Die Spaltensortierung kann man auch nicht ändern. Damit man die Crawldaten bearbeiten kann, muss man sie exportieren und in einer Tabellenkalkulation öffnen.

Keine Handlungsempfehlungen

Audisto-Berichte formulieren keine Handlungsempfehlungen. Es gibt keine Anleitung, was zu tun ist, um den SEO-Optimierungsgrad der gecrawlten Website zu verbessern. Doch Hinweise (Hints) liefern Einblicke zu technischen Fehlkonfigurationen und über SEO-Potenziale. Sie richtig zu interpretieren und geeignete Maßnahmen zu formulieren, ist Aufgabe des Anwenders. SEO Neueinsteiger sind wohl schnell überfordert.

Tooltips sind hilfreich

Tooltips sind sehr hilfreich. Leider sind sie nicht für jeden Crawl-Bericht verfügbar. Es wäre nützlich, wenn alle Berichte einen aussagekräftigen Tooltip bereitstellen. Denn es fühlt sich gut an, wenn man ein Tooltip liest und weiß, dass man die Daten von einem Crawl-Bericht auch richtig verstanden hat.

Tipp Cluster als Filter verwenden

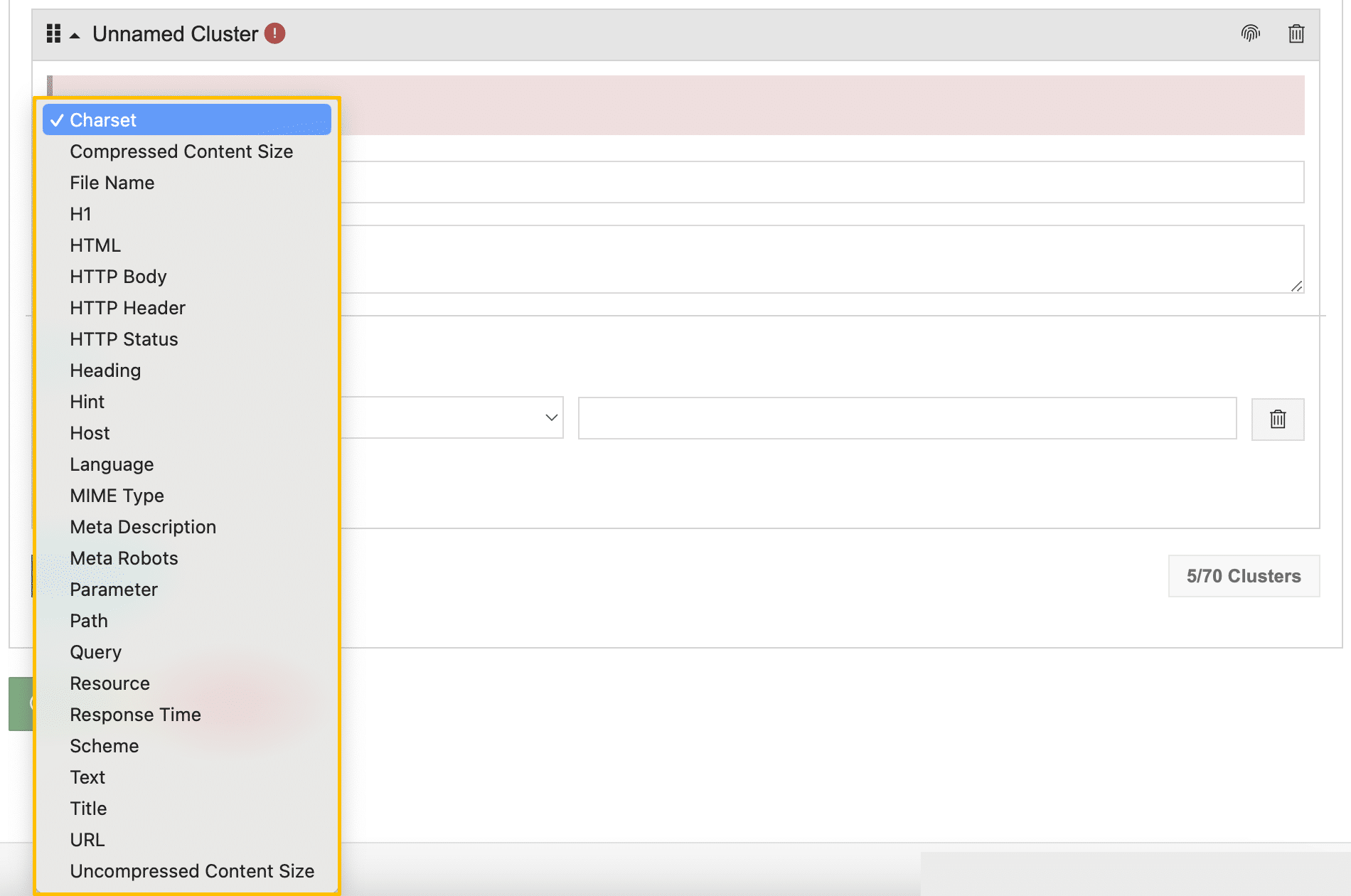

Eine hilfreiche und von mir intensiv genutzte Funktion von Audisto sind Cluster. Hierbei handelt es sich um Filter, die man in den Projekt-Einstellungen festlegen kann. Cluster haben den Zweck, die Crawldaten nach individuellen Mustern zu sieben.

Angenommen man möchte Web Vitals ausschließlich für indexierbare Seiten eingrenzen, dann erstellt man zunächst ein entsprechendes Cluster. Anschließend führt man einen weiteren Crawl durch. Im Audisto-Bericht findet man nun zusätzlich Web Vitals-Daten für das Cluster.

Man kann auch verschachtelte Cluster erstellen, denn als Filterkriterium stehen die im Audisto verfügbaren Hints (Hinweise) bereit. So ist es möglich ein Cluster zu erstellen, um alle indexierbaren Seiten (Meta Robots index) mit Canonical Tag zu einer anderen URL zu erfassen. Je intensiver man Autisto einsetzt, desto mehr wird man die Möglichkeiten der Cluster schätzen.

Allerdings gibt es auch Einschränkungen. Möchte man zum Beispiel alle internen Seiten mit dem Meta Robots noindex filtern, die gleichzeitig in einer XML Sitemap erfasst sind, ist das nicht möglich, weil das Filterkriterium für die XML Sitemap nicht vorhanden ist. Man kann also nicht für jedes Kriterium ein Cluster erstellen, weil man abhängig von den Vorgaben ist. Trotzdem sind Cluster sehr effektiv in Audisto.

Simulationen durchführen

Der Audisto Crawler eignet sich hervorragend, um Optimierungen vor der technischen Realisierung zu simulieren und deren Auswirkungen zu bewerten. Beispielhaft kann eine individuelle robots.txt-Datei (Custom robots.txt) in den Einstellungen definiert werden. Dadurch kann man diverse Optimierungen der Crawlability simulieren.

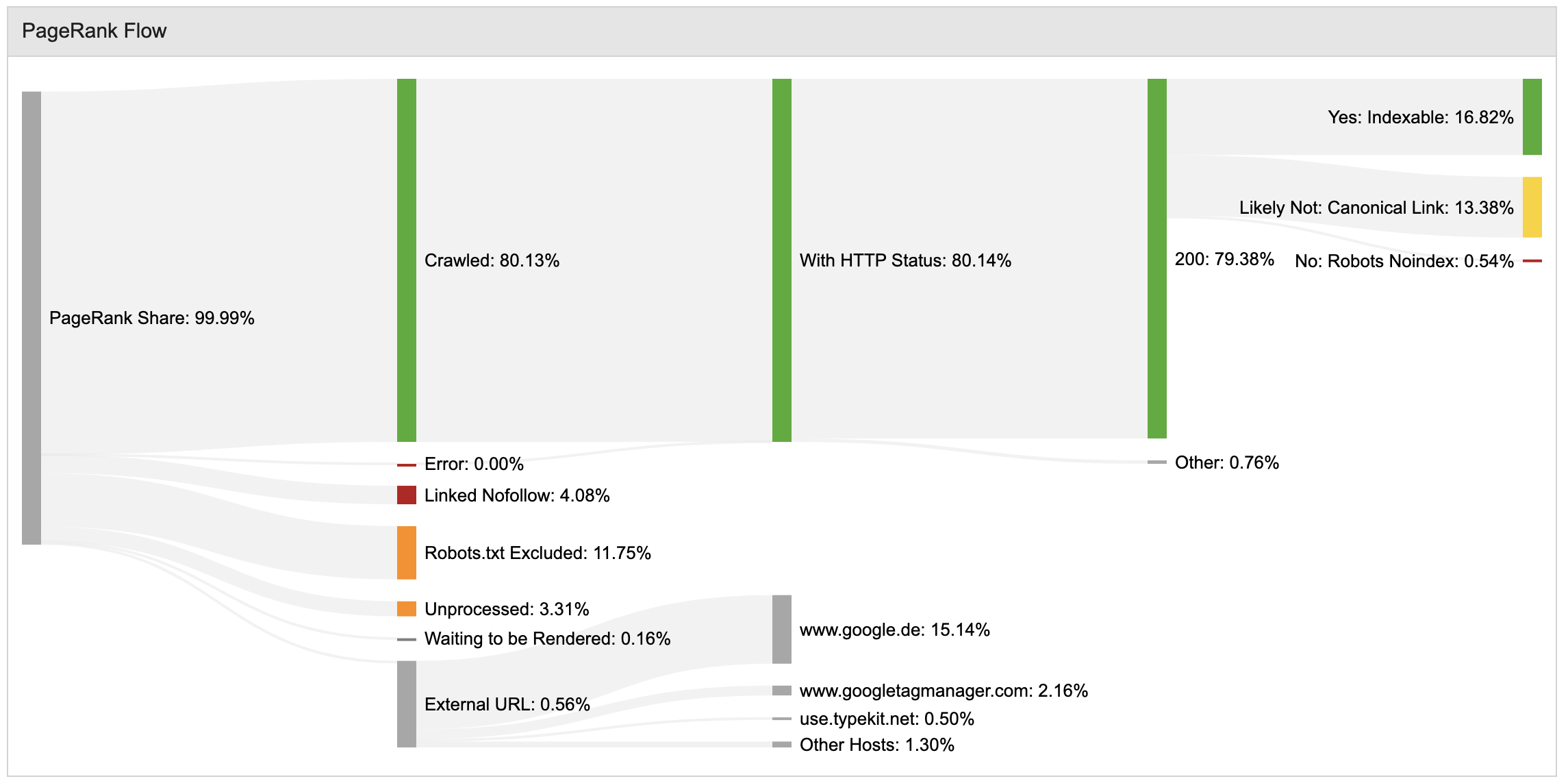

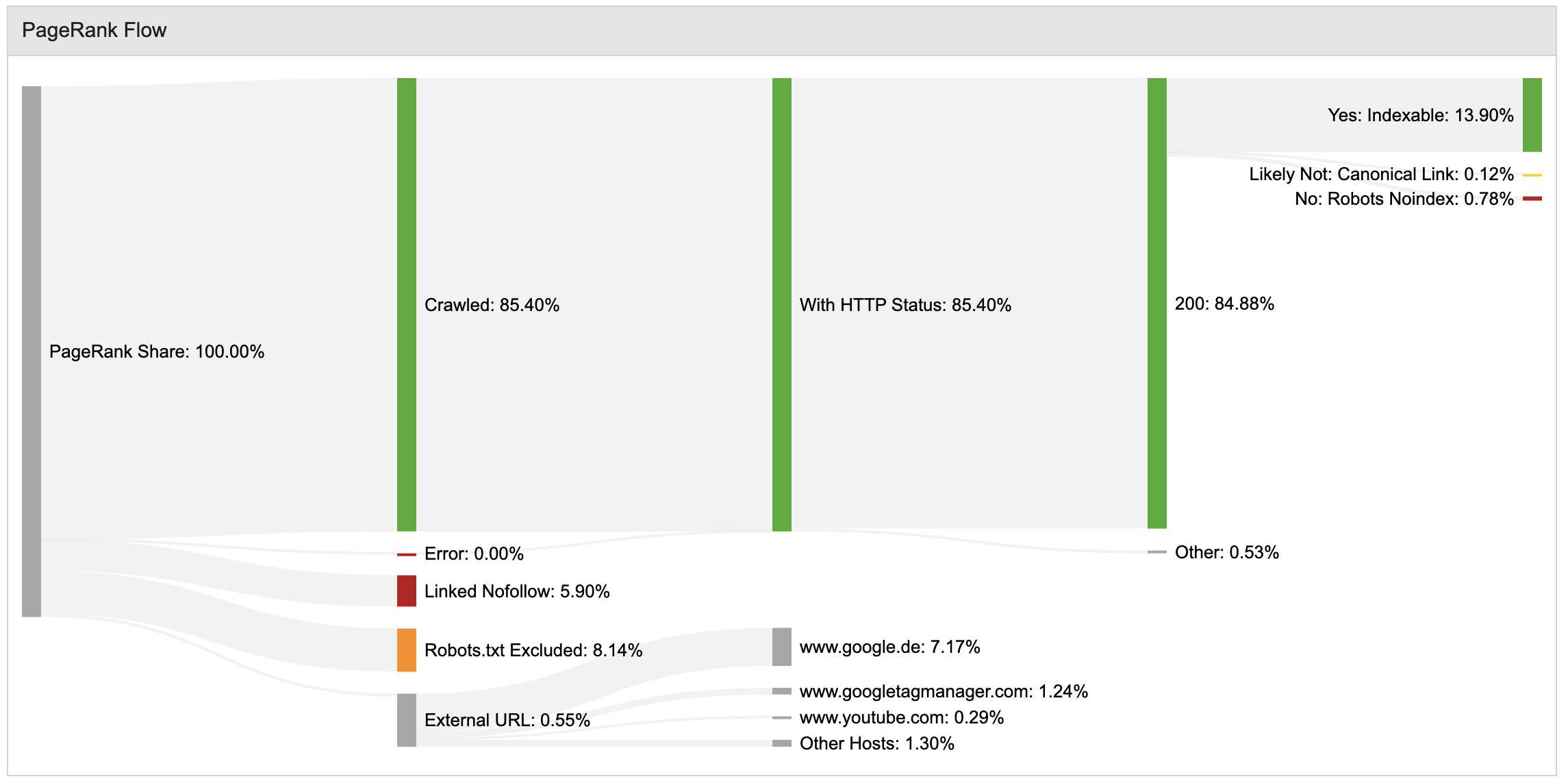

Eine ebenfalls mächtige Funktion ist die Verwendung von URL Rewrites. Durch diese Regeln kann man URLs für das Crawling sperren, Sitzungs-IDs loswerden, fehlerhafte Pfade korrigieren oder Parameter verwerfen. Letzteres ist sehr hilfreich bei großen Onlineshops, die viele Parameter nutzen, wodurch jedoch interner PageRank unnötig vergeudet wird. Durch URL Rewrites kann man ungewünschte Parameter in der URL verwerfen und so simulieren, wie sich der interne PageRank Flow verbessert.

In diesem Beispiel habe ich einen größeren Shop mit Audisto gecrawlt, der eine Vielzahl von Parameter URLs besitzt. Die URLs werden durch ein Canonical Tag zu einer anderen URL entwertet. Interner PageRank wird verschwendet.

Anschließend habe ich für das Projekt URL Rewrites erstellt, die eine Vielzahl unnötiger Parameter entfernen. Die Simulation zeigt, dass der interne PageRank deutlich effektiver genutzt wird.

Der PageRank Report enthält eine Vielzahl von sehr hilfreichen Widgets. Ich kenne keine andere Crawl Software, die PageRank-Berechnungen in diesem Detailgrad bereitstellt. Das PageRank Flow-Diagramm ist ein Killer Feature von Audisto.

Gruppierungen verschaffen mehr Überblick

Nützlich finde ich auch die Gruppierung von Daten, um Hinweise schnell zu bewerten. Der Crawl Report liefert beispielsweise Hinweise über Duplicate Title. Ein Klick auf den Hint und die Daten werden gruppiert dargestellt. In meinem Beispiel werden die doppelten Meta Title durch paginierte Seiten einer logischen Sequenz erzeugt. Gruppierungen finde ich hilfreich.

Performance-Berichte jetzt mit Web Vitals

Die Audisto Performance-Berichte wurden um Web Vitals erweitert. Sie liefern einen Überblick zu den SEO-relevanten Core Web Vitals für alle URLs und projektspezifische Cluster. Die Performance Daten stehen auch im URL Report für einzelne Seiten zur Verfügung. Auch hier muss der Anwender die richtigen Rückschlüsse ziehen, weil keine Handlungsempfehlungen bereitgestellt werden. Es wird also vorausgesetzt, dass der Anwender mit Web Vitals vertraut ist.

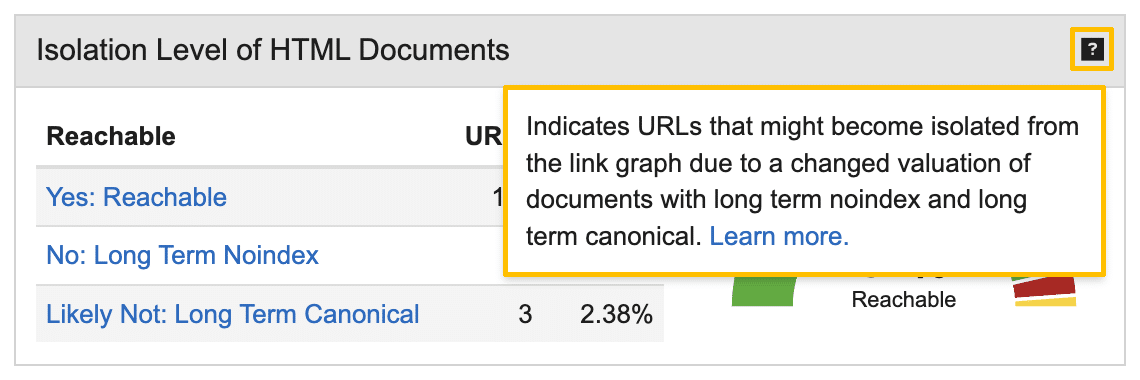

Isolation Level of HTML Documents

Ein interessantes Widget im Crawl Report ist Isolation Level of HTML Documents, also den Isolationsgrad aller HTML-Dokumente. So erfährt man, wie viele Seiten offenbar von Langzeit-Noindex und Langzeit-Canonical negativ betroffen sind.

Dabei kann es passieren, dass wichtige Seiten vom Rest des Linkgraphen isoliert und nicht mehr gecrawlt und indiziert werden. Die Informationen sind also sehr hilfreich, um die Indexierbarkeit von einer Website oder von einem Shop zu bewerten und zielführend zu optimieren.

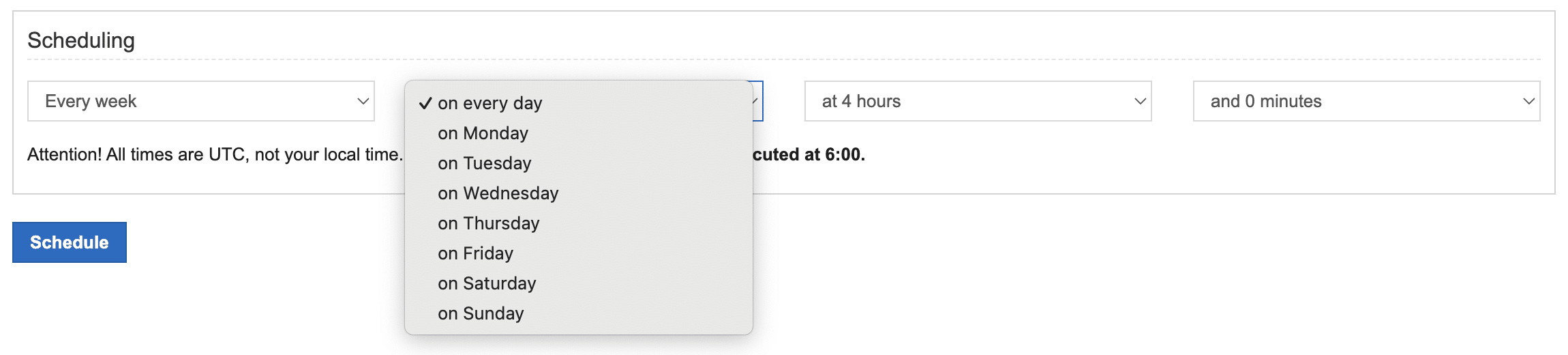

Crawl History

Audisto bietet die Möglichkeit, Crawls zu planen und automatisiert ausführen zu lassen. Diese Art von SEO-Controlling ermöglicht es, SEO-Trends zu erfassen und neue Projekt-Zustände aufzudecken. Das Crawling-Intervall kann individuell festgelegt werden, auch täglich.

Ich finde die Funktion hilfreich und empfehle sie für jedes Projekt zu aktivieren. Denn die Crawl History stellt wichtige SEO-Erfolgsfaktoren übersichtlich in einem Dashboard bereit. So erhält man einen anschaulichen Überblick zu kurzfristigen Trends und über wichtige Website-Zustände. Tipp: Die Crawl History lohnt sich auch für eine Staging- oder Produktionsumgebung zu aktivieren, um beim Entwicklungsprozess aussagefähig zu sein und schnell eingreifen zu können.

Der Bericht Crawl History of Indexable ist beispielsweise hilfreich, um schnell zu erfassen, ob sich die Indexierbarkeit von Seiten, verglichen mit einem beliebigen vorherigen Crawl, verändert hat. Das finde ich visuell gut gelöst.

Audisto Monitoring

Ergänzend zum Audisto Crawler kann ein Audisto Monitoring gebucht werden. Dieses Tool ermöglicht automatisierte Website-Tests und technische SEO-Überwachung im großen Maßstab, um die Testabdeckung über jede einzelne Seite einer Website ohne Stichproben zu gewährleisten.

Features

- Sichern der Website-Elemente, um Konformität und Qualität zu erhalten

- Kritische Warnungen in Echtzeit

- Kontinuierliche Testabdeckung einschließlich vollständiger KPI-Historie

- Zeitersparnis für Qualitätsmanagement und Entwickler durch vollständig automatisierte Tests

- Crawler-basierte Überwachung ermöglicht Website-Tests auf Nutzerebene

- Automatisiertes SEO-Monitoring mit allen Funktionen des Audisto-Crawlers

- Handlungsfähige mehrstufige Überwachungs-Dashboards

- Schnelle Revisionen problematischer Änderungen

- Compliance-Warnungen für Produktseiten

- Kontinuierliche und automatische Alarmierung durch kritische Warnungen in Echtzeit und anpassbare Testintervalle

Preise

Audisto Monitoring basiert auf dem selben Konzept, wie der Audisto Crawler. Denn für ein Monitoring-Projekt bestimmt man die Anzahl der zu crawlenden URLs. Das erfolgt anhand eines skalierbaren Schiebereglers, mit dem man den Crawlumfang zwischen 100.000 und bis zu 50.000.000 crawlbare URLs festlegt. Der Umfang bestimmt den Preis, beginnend ab 649,00 EUR bei monatlicher Zahlung. Für längerfristige Projekte kann jährliche Zahlung mit Rabatt gewählt werden.

Kommentar verfassen