Mit dem X-Robots-Tag werden Indexierungs- und Bereitstellungsregeln für eine Webseite festgelegt, etwa ob sie von Suchmaschinen indexiert werden darf. Das X-Robots-Tag wird im HTTP-Header der Seite angegeben.

Wenn kein Meta Robots Tag oder kein X-Robots-Tag bereitgestellt wird, dann interpretieren User-agents die Seite mit der Regel index,follow (darf indexieren und den Verlinkungen im HTML-Code folgen). Das X-Robots-Tag verwendet die selben Regeln, die für das Meta Robots Tag gelten.

Inhaltsverzeichnis

X-Robots-Tag verwenden

Das X-Robots-Tag kann als Element der HTTP Header-Antwort für eine URL verwendet werden, zum Beispiel:

|

1 2 3 4 5 |

HTTP/1.1 200 OK Date: Tue, 13 June 2018 12:50:43 GMT (…) X-Robots-Tag: noindex (…) |

In der HTTP-Antwort können beliebig viele X-Robots-Tag-Header kombiniert oder eine durch Kommas getrennte Liste von Regeln bereitgestellt werden – zum Beispiel für einen HTTP Header mit den Regeln noarchive und unavailable_after.

|

1 2 3 4 5 6 |

HTTP/1.1 200 OK Date: Tue, 13 June 2018 12:50:43 GMT (…) X-Robots-Tag: noarchive X-Robots-Tag: unavailable_after: 25 Jun 2018 15:00:00 PST (…) |

Im X-Robots-Tag kann bei Bedarf ein User-Agent notiert werden, für den die Regeln gelten:

|

1 2 3 4 5 6 |

HTTP/1.1 200 OK Date: Tue, 13 June 2018 12:50:43 GMT (…) X-Robots-Tag: googlebot: index X-Robots-Tag: semrushbot: noindex, follow (…) |

Indexierungs- und Bereitstellungsregeln ohne Angabe von einem User-Agent sind für alle User-agents gültig. Groß- und Kleinschreibung muss weder beim Namen noch bei den verwendeten Regeln beachtet werden.

Indexierungs- und Bereitstellungsregeln

Hinter dem Doppelpunkt nach X-Robots-Tag: können eine oder mehrere Regeln stehen. Sie dürfen sich nicht gegenseitig ausschließen. Die Verwendung von index und noindex darf nicht für die selbe Seite erfolgen. Das gilt auch für follow und nofollow.

| Regel | Erklärung |

| all | Es bestehen keine Einschränkungen. |

| index | Die Seite darf in den Suchergebnissen erscheinen und der Link „im Cache gespeichert“ angezeigt werden. |

| noindex | Die Seite darf nicht in den Suchergebnissen erscheinen und kein Link „im Cache gespeichert“ angezeigt werden. |

| follow | Der Crawler darf den Links auf der Seite folgen. |

| nofollow | Der Crawler darf den Links auf der Seite nicht folgen. |

| none | Entspricht der Anweisung: „noindex,follow“. |

| noarchive | Es darf kein Link „im Cache gespeichert“ in den Suchergebnissen erscheinen. |

| nosnippet | Es darf kein Snippet für diese Seite in den Suchergebnissen erscheinen. |

| noodp | Es dürfen keine Meta Informationen aus dem Open Directory Project dieser Seite angezeigt werden. Das ODP wurde 2017 geschlossen. |

| notranslate | Es darf keine Übersetzung dieser Seite in den Suchergebnissen erscheinen. |

| noimageindex | Es dürfen keiner Bilder dieser Seite indexiert werden. |

| unavailable_after: [RFC-850 date/time] | Diese Seite darf nach dem angegebenen Datum bzw. der angegebenen Uhrzeit nicht mehr in der Websuche angezeigt werden. Das Datum bzw. die Uhrzeit muss im RFC 850-Format angegeben werden. |

Um das X-Robots-Tag auf einem Apache-Server zu nutzen, fügt man den folgenden Code in die .htaccess- oder httpd.config-Datei der Website ein.

|

1 2 3 4 |

# X-Robots-Tag-Header für eine einzelne statische Seite <Files "beispiel.html"> Header set X-Robots-Tag "noindex,follow" </Files> |

Bei einem Nginx-Server, fügt man folgende Anweisung in die .conf-Datei der Website ein:

|

1 2 3 4 |

# X-Robots-Tag-Header für eine einzelne statische Seite location = /beispiel.html { add_header X-Robots-Tag "noindex, follow"; } |

Noindex und Canonical Tag

X-Robots-Tag versus robots.txt

Häufig liegt ein Missverständnis zwischen der robots.txt-Datei und dem X-Robots-Tag vor: Anweisungen in der robots.txt-Datei legen fest, welche Ressourcen Suchmaschinen und Scraper verarbeiten bzw. crawlen dürfen. Dagegen weist das X-Robots-Tag an, ob Crawler eine Seite indexieren und den Links im HTML-Code folgen dürfen. Wird eine Seite durch eine robots.txt-Anweisung von der Verarbeitung/Crawling ausgeschlossen, sollte die X-Robots-Tag-Regel noindex festgelegt werden.

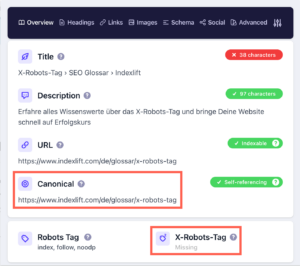

X-Robots-Tag prüfen

Ob ein X-Robots-Tag für eine Seite gesetzt wird, kann schnell mit dem Web Developer-Plugin (Chrome und Firefox) analysiert werden: „Information“ – „View Response Headers“

Es gibt auch viele andere Möglichkeiten, die Indexierungs- und Bereitstellungsregeln einer Seite im Browser anzuzeigen, zum Beispiel mit SEO META IN 1 CLICK oder mit der Ahrefs SEO Toolbar.