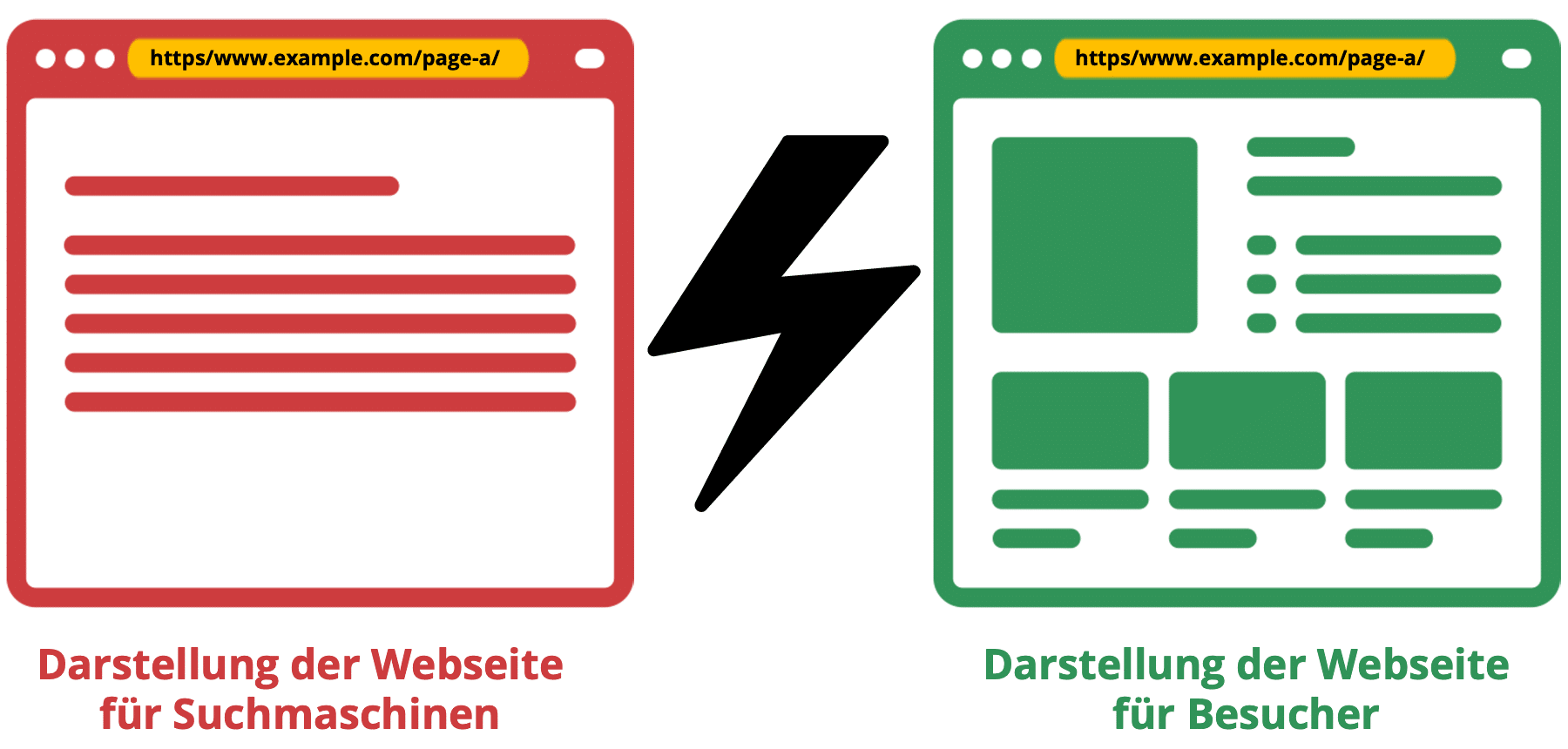

Cloaking stammt vom englischen Begriff cloak (Umhang; Mantel). Bei dieser zweifelhaften Praktik werden dem Besucher und Suchmaschinen-Crawlern unterschiedliche Inhalte für die selbe Seite bereitgestellt. Während dem Besucher ansprechend gestaltete Inhalte mit Bildern und Videos angezeigt werden, wird Suchmaschinen-Crawlern im HTML Code für die selbe URL viel Text angeboten, um bessere SEO-Rankings zu generieren. Das kann zum Ausschluss in Suchmaschinen führen.

Inhaltsverzeichnis

Black Hat Cloaking und White Hat Cloaking

Cloaking wird meist bewusst mit der Absicht angewendet, die Suchmaschinenergebnisse (SERPs) für ausgewählte Keywords zu manipulieren. Es gibt auch unbeabsichtigtes Cloaking.

Black Hat Cloaking

Unterschiedliche Inhalte oder Informationen an Nutzer und Suchmaschinen auszuliefern, wird oft mit unethischen SEO-Praktiken in Verbindung gebracht. Black Hat Cloaking zielt darauf ab, das Suchmaschinen Ranking durch Täuschung zu manipulieren, indem für die Suchmaschinen optimierter Content präsentiert wird, den ein Besucher nicht sieht. Das verstößt gegen die Qualitätsrichtlinien von Google und anderer Suchmaschinenbetreiber.

White Hat Cloaking

White Hat Cloaking ist umstritten, weil die Definition von ethisch akzeptablem Cloaking nicht eindeutig ist. In manchen Fällen wird argumentiert, dass Cloaking für eine positive Nutzererfahrungen eingesetzt werden kann, wie barrierefreie Webinhalte für Menschen mit Behinderungen. Allerdings sehen viele Suchmaschinen jegliche Formen von Cloaking als Verstoß gegen ihre Spamrichtlinien an und können dafür Webseiten abstrafen oder aus dem Suchmaschinen Index entfernen, weil es das Prinzip der Gleichbehandlung von Nutzer und Crawler untergräbt.

Cloaking-Techniken in der Suchmaschinenoptimierung

IP-Cloaking

IP-Cloaking ist eine Technik im Bereich der Suchmaschinenoptimierung (SEO), bei der Inhalte abhängig von der IP-Adresse des Besuchers verändert wird. Wenn die IP-Adresse darauf hindeutet, dass der Besucher ein Suchmaschinen-Crawler ist, wird eine optimierte Seite präsentiert, die sich von der unterscheiden kann, die normale Nutzer sehen. Die IP-Adressen von Googlebot sind beispielsweise öffentlich bekannt.

User Agent-Cloaking

User Agent-Cloaking ist eine Technik im Bereich der Suchmaschinenoptimierung, bei der Inhalte abhängig vom User Agent (z. B. Googlebot) des anfragenden Nutzers unterschiedlich bereitgestellt werden.

Der User Agent ist eine Zeichenkette, die vom Browser oder Webcrawler gesendet wird und Informationen über den Typ des Browsers oder der Suchmaschine enthält.

Unbeabsichtigtes Cloaking

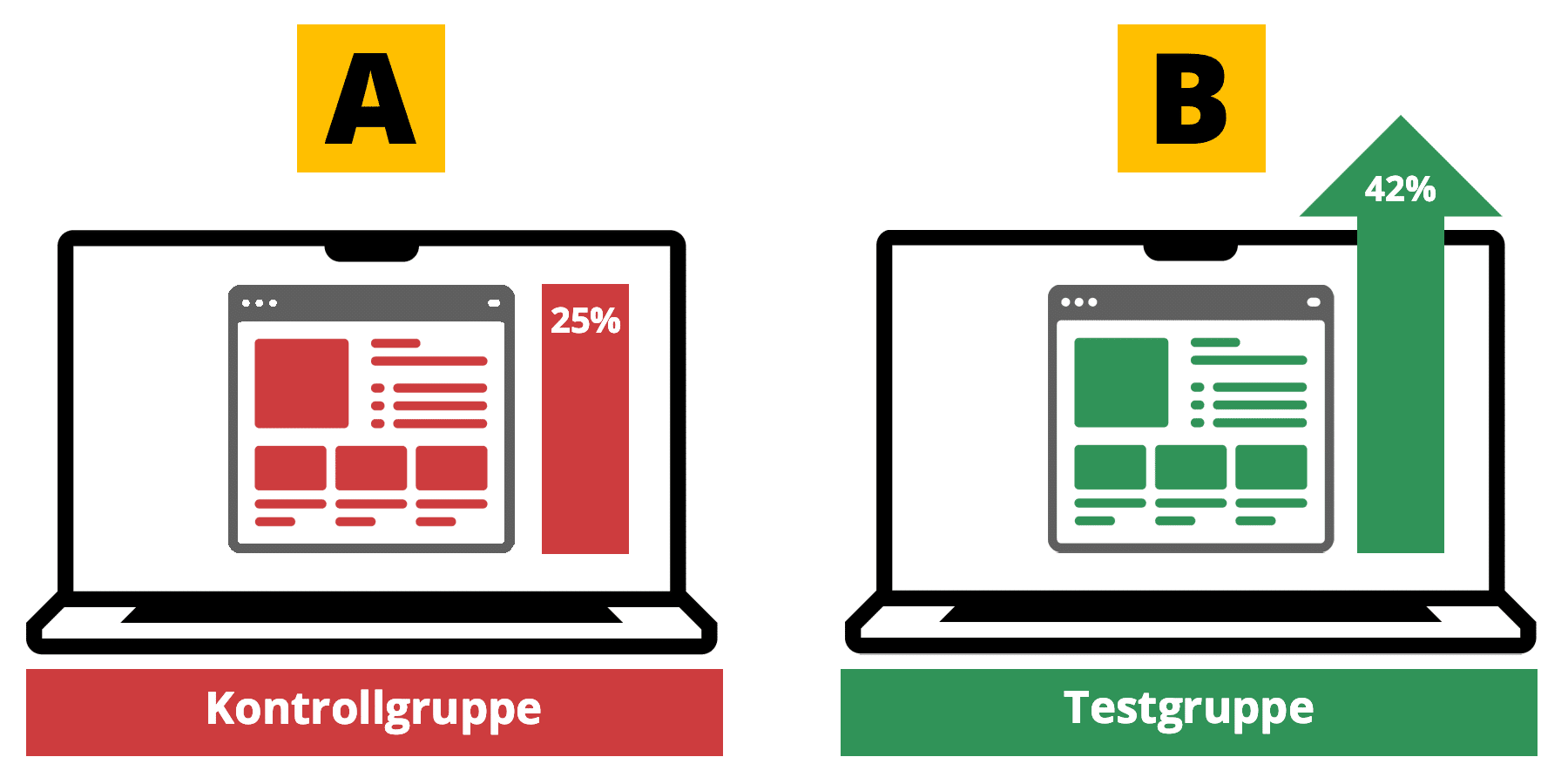

A/B-Tests können unbeabsichtigte Cloaking-Effekte erzeugen, die von Googlebot erkannt werden können. Die Lösung: Alle Test-URLs mit einem Canonical Tag auf die ursprüngliche URL versehen, um die organische Sichtbarkeit der Seite nicht zu beeinträchtigen.

Kein Cloaking-Spam für Suchmaschinen

Geotargeting

Geotargeting ist eine Technik, bei der Inhalte abhängig von dem Standort eines Besuchers geladen werden. Durch die Verwendung dieser Methode wird kein Seiteninhalt verhüllt, sondern lediglich die geeignete Sprachversion des Inhalts geladen. So wird dem Besucher der sich in Spanien befindet, auf Basis seiner IP-Adresse, die spanische Sprachversion des angefragten Inhalts vorgeschlagen bzw. geladen, statt die default Version.

Apple verfolgt eine smarte Methode, bei der ein Besucher nicht automatisch zur geeigneten Sprachversion geleitet wird. Statt dessen wird ihm die passende Sprache empfohlen:

User Agent Delivery

Auch User Agent Delivery ist kein Cloaking-Spam. Bei dieser Technik wird die mobile bzw. Desktop-Version einer Seite automatich geladen – abhängig vom Endgerät des Besuchers. User Agent Delivery wird immer seltener angewendet, weil die meisten Websites auf einem responsiven Webdesign aufbauen.

Best practices: Cloaking vermeiden

Um Cloaking zu vermeiden, sollten folgende Maßnahmen beachtet werden:

- Stelle sicher, dass Besucher und Suchmaschinen-Crawler denselben Inhalt sehen.

- Vermeide User Agent-basierte Umleitungen, die auf den Crawler abzielen.

- Verwende keine versteckten Texte oder Links, die nur für Suchmaschinen sichtbar sind.

- Beachte die Richtlinien für Webmaster der jeweiligen Suchmaschinen.

- Verwende keine Techniken, die Inhalte auf Basis der IP-Adresse des Besuchers variieren.

- Implementiere eine transparente und konsistente URL-Struktur.

Website auf Cloaking checken

Im Internet gibt es mehrere Seiten, die einen Cloaking Checker bieten, mit dem man eine Website auf Cloaking überprüfen kann, wie der Small SEO Tools Cloaking Checker. Auch empfehlenswert ist Google Safe Browsing-Websitestatus, um zu ermitteln, ob eine Website sicher ist.

Google sendet dem Webmaster auch weiterhin entsprechende Nachrichten über die Search Console, wenn eine gehackte Seite erkannt wurde.

Paywall-Inhalte und Content-Gating in der SEO

Paywall-Inhalte sind nur für zahlende Kunden oder registrierte Nutzer zugänglich. Häufig wird diese Technik auf Nachrichten-Websites eingesetzt. Das Vorhandensein einer Paywall ist nicht automatisch gleichzusetzen mit Cloaking, weil hierbei kein unterschiedlicher Inhalt an Suchmaschinen und Nutzer bereitgestellt wird. Suchmaschinen können meist erkennen, wenn Inhalte hinter einer Paywall verborgen sind, und bewerten diese entsprechend.

Content-Gating ist eine Marketingstrategie, bei der ausgewählte Inhalte nur bei Erfüllung bestimmter Bedingungen zugänglich sind. Zum Beispiel das Ausfüllen eines Formulars mit persönlichen Informationen, um eine Studie downloaden zu können. Zweck vom Content-Gating ist es, Leads zu generieren und mehr über die Interessenten zu erfahren. Es kann für Whitepapers, E-Books oder Webinare genutzt werden. Nachteilig kann sein, dass es Nutzer abschrecken kann.

Google schreibt hier: Wenn du eine Paywall oder einen Content-Gating-Mechanismus betreibst, betrachten wir dies nicht als Cloaking, solange Google den gesamten Inhalt hinter der Paywall sehen kann – genau wie jeder andere Nutzer, der Zugriff auf diese Inhalte hat.